2024年3月28日下午,由中国社会科学院哲学研究所伦理学研究室和中国社会科学院应用伦理研究中心举办的“应用伦理讲座”如期举行。该讲座得到中国社会科学院登峰战略科技伦理学新兴交叉学科资助。本次讲座主题为“人工智能的管理哲学与伦理趋势”,由北京大学哲学系陈少峰教授主讲,中国社科院哲学研究所所长张志强研究员主持,中国社科院哲学研究所张永义研究员和中国社科院哲学研究所王幸华副研究员担任评议。参与讨论的人员有中国社科院哲学研究所伦理学研究室甘绍平研究员、徐艳东副研究员、侯杰耀助理研究员以及其他学科方向的研究人员和来自中国社会科学院大学的同学们。讲座伊始,张志强所长介绍了陈少峰教授的学术背景,表达了对陈少峰教授的欢迎,并邀请陈少峰教授开讲。

一、陈少峰教授的讲解

陈少峰首先对讲座的研究视角进行了介绍:首先,研究人工智能的管理哲学与伦理趋势是研究实践与关于实践的理论,这种实践视角偏向于对民生问题的重视与对提高生活质量问题的思考;其次,上述研究多数是跨界问题、混搭问题,并且涉及多方利益冲突,比如如何找到政策、企业、技术与伦理的结合点;最后,上述研究关切“趋势分析”和预判的问题,比如在技术演进的趋势中产生的系列问题。

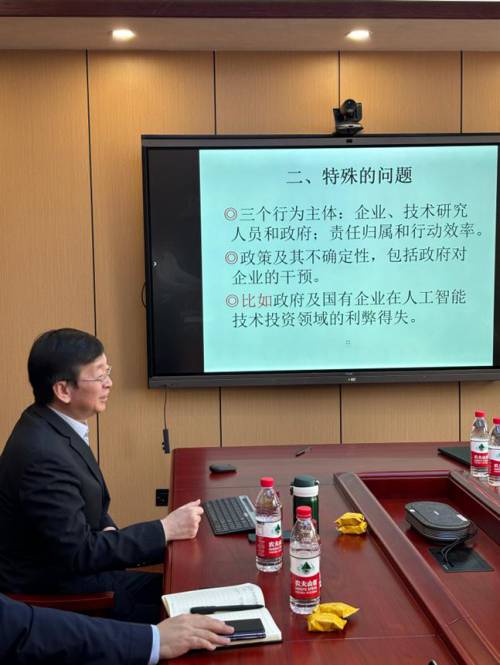

之后,陈少峰对人工智能的管理哲学与伦理趋势研究中的特殊问题进行了说明:首先,在人工智能的发展活动中具有三个行为主体:企业、技术研究人员、政府,这带来了复杂的责任归属问题,三者之间的协调也对行动效率产生影响。其次是政策及其不确定性的问题,比如如何平衡人工智能发展带来安全风险与人工智能产业的发展效率之间的矛盾关系。

随后,陈少峰谈到了他对人工智能的预判:陈少峰认为,人工智能是指一种智能化程度高、软硬件结合、技术持续发展的综合系统;AGI及以上的技术会在模仿、学习、创新能力得到提升;人工智能机器人将全面超越人类;机器人可以创造机器人乃至创造“真人”;人和机器人结婚可能成为新常态;能否做到正确预判其影响、做出取舍与决策与改进预判的责任机制成为重要问题。

陈少峰提出了人工智能的发展与治理能否防患于未然的问题并对此做出回应,他认为难以防患于未然有以下理由:伦理问题是逐次出现的,在问题出现之前很难凝聚共识;研发暂停造成的投资损失和可预见收入缺失可能带来补偿或赔偿问题,这可能影响措施比如“暂停措施”的有效性;鉴于目前授予联合国暂停键的议案被否决,联合国的集体行动难以成立;人工智能几乎不需要在人体上做有害实验,因此难以从这一点出发进行管制。然而,陈少峰认为,科技主导方与优势方带头采取措施或许可以改善局面。

陈少峰介绍了人工智能的发展现状与应用场景的几个观察视角:人工智能与经济、社会、意识形态、科技发展、军事国防等各个领域都是一盘棋;人工智能具有超级广泛的应用,预计10年内70%产业与人工智能有关,这带来了机器训练的管控和意识形态的问题。陈少峰还介绍了机器人的四个阶段:编程自动控制机器人,这并非人工智能而是相当于机器自动化生产线,主要用于自动化的制造业;内容生产机器人,它可以自主标注数据而不是人工输入数据;陪伴机器人,可以起到部分的陪伴功能;伙伴机器人,包括真人与机器人进行同居生活乃至缔结婚姻关系。陈少峰谈到了人工智能发展与大国冲突的问题、人工智能与国防安全的问题。

之后,陈少峰介绍了其管理哲学的方法论面向:管理哲学作为一种方法,可以解决诸如企业决策及政府干预企业的伦理后果及其相关问题。陈少峰介绍了两个例子:首先是企业董事会构成中的专业型思维人才和战略型思维人才的区分,陈少峰指出了两种人才在董事会占比中的中西差异,指出要提高战略型思维人才比例才能把握大局做好决策;其次是对独立董事的制约效果与责任承担合理性的分析。

陈少峰介绍了人工智能即将展现的伦理问题:

1. 不涉及人体与涉及人体的人工智能实验带来的“持续性”问题。“持续性”问题关注连续不断产生的相互联系的多元影响。2.人工智能的自主性与人类命令之间的矛盾。3.数据泄露的严重后果,其后果不仅仅关涉公民的隐私权还关涉国家的数据安全。4.机器人婚姻问题,诸如为了养育后代的需要,机器人配偶是否具有财产继承权的问题。5.在不缺乏劳动力的时代人类如何定位生活的相关问题。6.将人的记忆植入机器人由此带来的数字永生问题。7.对传统文化的挑战:可能出现的人-机共存的社会。8.机器人价值地位的问题,诸如机器人需不需要主动标明身份、对机器人的歧视能否被证成、机器人使用是否需要纳税、甚至机器人会不会厌弃真人的问题。9.机器人用于军事的问题,诸如人工智能+无人机对反导系统的影响。10.机器人行为的责任主体归责问题,比如派机器人执行任务,机器人理解不了场景带来破坏性后果该由谁承担的问题。

最后,陈少峰基于管理哲学的视角对上述问题提出了对策和建议:

1.要确定优先原则事项。2.要有针对性地进行具体管控,结合技术细化管控筛选,平衡管控与发展之间可能的内在矛盾,在人工智能的应用层面上尤其不能落后。3.理清主次责任,技术优势与获利者应当承担更多伦理责任,以避免技术失控。4.需要关注机器人应用中的各种伦理问题,但不应局限于伦理视角,还要结合国家战略等进行多元综合分析,融合大局观与具体措施。5.对于利益机器人造人(比如具备消化系统的高仿生物人)要持特别警惕态度。6.认识到联合国在人工智能具体管控问题的局限性,不能将联合国视为依赖性手段,要注重合理划分“大国责任”,比如先发国家可能应该承担更多责任。7.我国要以经济发展为重心发展人工智能,带动以企业和国防军事为核心的人工智能应用场景的发展。8.区分人工智能的“防守型”和“进攻型”领域,针对“进攻型”领域要积极预判、立法和制定政策,发挥专业人士在立法过程中的作用。9.把握“新质生产力”,平衡人工智能可能带来的就业冲击,让人工智能的研究保持在合理速度。

二、评议环节

评议首先由王幸华副研究员展开:

王幸华指出,从AlphaGo到ChatGPT、Sora,人工智能相关问题向来持续获得学界关注。王幸华感谢陈少峰为大家带来了一场“扫盲式”的讲座,感谢陈少峰老师为大家介绍了人工智能可能在更多领域超越人类的问题所引发的思考、如何面对这些挑战以及涉及到的管理哲学问题。

王幸华再次点明了陈少峰对人工智能的管理哲学的界定:“人工智能的管理哲学是指如何利用人工智能造福人类,以及如何对人工智能即将出现的问题进行前瞻性预判,思考相关的对策”,其中,“人工智能是指一种智能化程度高、软硬件结合、技术持续发展中的综合系统”。王幸华列举了讲座提到的人工智能带来的就业冲击问题,以及陪伴型机器人、劳动型机器人、手术机器人、军事机器人的相关问题,提出了在多大程度上机器人可以是一个负责任的主体的问题。

随后,王幸华介绍了阿西莫夫的机器人学三定律:第一定律:机器人不得伤害人,也不得见人受到伤害而袖手旁观;第二定律:机器人应服从人的一切命令,但不得违反第一定律;第三定律:机器人应保护自身的安全,但不得违反第一、第二定律。王幸华指出阿西莫夫机器人学三定律某种程度上将机器人视为权利主体,或许可以为人工智能治理问题提供有效借鉴。但王幸华也指出了阿西莫夫机器人学三定律可能存在的实践冲突:第一定律和第三定律的冲突,即如果人类要求人工智能机器人伤害其他人,机器人是否应该服从人类;第二定律和第三定律的冲突,即如果人类要求机器人损伤自身,机器人是否应该服从人类;第一定律和第三定律的冲突,即在一些情况下,机器人为了自保可能不得不伤害人。

王幸华讨论了机器人的权利与人的权利的关系问题。在机器人的权利上,一方面,机器人有没有权利,有什么权利?比如,第三定律优先级低于第一与第二定律是否会对机器人不公平?如果未来的人工智能机器人与人类极为相似,是有思维的存在者,可以与人类结婚,那么是不是不应该否认它们的权利?另一方面,机器人的权利与人的权利或利益相冲突时应该怎么办?

最后,王幸华讨论了人工智能的管理问题。第一,如何有效管理机器人,防止机器人伤害人类?王幸华引用了威廉斯的思想实验:设想有一种外星生物降临地球,它们拥有漂亮的外表,发达的理性,善良的内心,以及比人类成功得多的星球管理经验。经过深入研究,它们发现,人类的活动给地球带来了毁灭性的影响,只有将人类这个物种铲除,才能拯救地球以及生活在地球上的其他生物。于是,外星人决定用一种无痛的方式消灭人类以及人类的全部偏见。这时,作为一个人类,你将如何应对?你是愿意做一名“抵抗者”,与外星人顽抗到底,还是要做一个“合作者”,为了地球的福祉,配合外星人将其他人类铲除,最后再自杀?第二,如何处理人与机器人的关系。王幸华提出,把机器人视为给人类提供服务的某个东西(a thing)是否会助长人类心灵中作为恶的一面的控制欲与奴役欲、虚荣与骄傲?

随后是张永义研究员的评议:张永义指出陈少峰老师的讲座为大家讲解了人工智能的现状、特性、未来发展和图景,介绍了管理哲学及其与现实贴近的相关伦理问题以及管理哲学视角下的对策,既深刻又有前沿性和现实性,给大家带来了深入的学习。

张永义分析了本次讲座中的几个新颖和独到之处:重视民生与重视生活质量的提高的研究视角;对人机共同体的社会的可能未来图景的设想;人工智能带来的道德困境和伦理悖论,比如对传统文化的冲击、人工智能使用税、人工智能手术、人工智能婚姻等。

张永义指出,人工智能的管理哲学研究要求不再固守单一伦理立场诸如情感主义、快乐主义、后果主义、契约论等等,而是结合具体问题、就事论事,采用多元化的思维方式,采取多维主体参与治理的方法,进行滚动式“持续性”研究。

张永义提到了清华大学人工智能国际治理研究院的研究成果,结合并介绍了布莱切利宣言,介绍与分析了人工智能发展的四大思维:底线思维、人本思维、发展思维和全球思维,并分析了上述研究与陈少峰讲座主旨的相关性。

张永义指出:人工智能的责任认定问题是重要与疑难问题,能产生致命后果的“自主致命体”应该被限制开发。张永义还介绍了目前人工智能发展中隐私与数据训练之间的矛盾。

三、提问与讨论环节

本次讲座中来自会场的评议与回答也十分精彩:

甘绍平研究员针对“机器人”概念提出问题:“机器人”应该被看做“机器”还是“人”?如果被看作“机器”,看作人的工具,那就不会产生什么伦理问题,也不会对伦理学研究造成什么疑难;如果将“机器人”是当作人,那么按照人的标准这肯定很成问题:人不仅具有理性逻辑,还有潜意识、冥想顿悟、情感直觉和创造性的思维,这一点并没有在硅基生命之中发现;根据康德的观点,人具有开启新的因果链条的能力、拥有自由和尊严,这一点人工智能也难以做到。同时,作为目的而非仅仅手段的人类似乎也不会允许为人所造的自主性人工智能对人类的过度干预,反而会尽力阻止其失控行为的发生,避免异化现象;基于上述观点和其他相关论述,甘绍平认为,人工智能肯定不会成为与人类对等的伦理主体,因此人工智能与人类的婚姻没有可能性。对此,陈少峰回应:在实际应用与生活中,因为机器人的“类人性”,在情感上和心理地位上将“机器人”赋予人的地位对可能并非少数的部分人可能确实发生。

会场有参会成员提问:赛博格(人机结合)路线比起人工智能路线是否更会带来对现有人类的“法西斯主义”?陈少峰回应认为两者进路并不能截然分开,同时人工智能路线确实具有强烈风险,值得特别关注。还有成员提问如何看待人工智能发展过程中美国的以企业主体与中国的以国家主体之间的区别?陈少峰回应认为:应该进行主体互补、兼顾发展,以技术发展为核心。还有成员对如何理解“持续性干预”进行提问,陈少峰回应持续性干预既包括研发训练阶段也包括产出应用阶段,同时干预应该是有针对性的而非全面控制式的。

最后,本次讲座主办方向陈少峰教授致以诚挚的感谢,讲座在一片掌声中圆满结束。

(整理人:中国社会科学院大学本科生,杨作豪)